W artykule opublikowanym niedawno w Biologia PLoSNaukowcy zrekonstruowali utwór muzyczny z nagrań neuronowych, korzystając z modelowania obliczeniowego, badając przestrzenną dynamikę neuronową leżącą u podstaw percepcji muzyki, korzystając z modeli kodowania i analizy ablacji.

Pobyt: Muzykę można zrekonstruować na podstawie aktywności ludzkiej kory słuchowej za pomocą nieliniowych modeli dekodowania. Źródło zdjęcia: LianLeonte/Shutterstock

tło

Muzyka, uniwersalne ludzkie doświadczenie, aktywuje wiele tych samych obszarów mózgu, co mowa. Badacze zajmujący się neuronauką przez wiele lat śledzili neuronalne podstawy percepcji muzyki i zidentyfikowali wyraźne neuronalne korelaty elementów muzycznych, w tym barwę, melodię, harmonię, wysokość i rytm. Jednak nadal nie jest jasne, w jaki sposób te sieci neuronowe współdziałają w przetwarzaniu złożoności muzyki.

„Jedną z rzeczy, które dla mnie są związane z muzyką, jest to, że zawiera ona prozodię (rytmy i tony) oraz treść emocjonalną. W miarę postępu w dziedzinie interfejsów mózg-maszyna badania te mogą pomóc w nadaniu muzykalności przyszłym implantom mózgowym dla osób niepełnosprawnych” – wyjaśnia. Zaburzenia neurologiczne lub rozwojowe wpływające na mowę.

-lekarz. Roberta Knighta z Uniwersytetu Kalifornijskiego w Berkeley

O badaniu

W bieżącym badaniu naukowcy wykorzystali rekonstrukcję bodźców do sprawdzenia, w jaki sposób mózg przetwarza muzykę. Wszczepili 2668 elektrod elektrokortykograficznych (ECoG) na 29 powierzchniach korowych pacjenta neurochirurgicznego (mózgu), aby rejestrować aktywność neuronową lub zbierać dane elektroencefalograficzne (iEEG), biernie słuchając trzyminutowego fragmentu piosenki Pink Floyd: „Another Brick W ścianie, część pierwsza.

Stosowanie słuchania pasywnego jako metody prezentacji bodźców zapobiega myleniu neuronowego przetwarzania muzyki z aktywnością motoryczną i podejmowaniem decyzji.

Na podstawie danych z elektrod 347/2668 zrekonstruowali utwór, który bardzo przypominał utwór oryginalny, choć z mniejszą szczegółowością – np. słowa w zrekonstruowanej piosence były znacznie mniej wyraźne. W szczególności zastosowali modele dekodowania oparte na regresji, aby dokładnie zrekonstruować bodziec słuchowy (w tym przypadku trzyminutowy fragment piosenki) na podstawie aktywności neuronowej.

W przeszłości badacze stosowali podobne metody do rekonstrukcji mowy na podstawie aktywności mózgu; Jednak po raz pierwszy podjęli próbę rekonstrukcji muzyki przy użyciu takiego podejścia.

iEEG charakteryzuje się wysoką rozdzielczością czasową i doskonałym stosunkiem sygnału do szumu. Zapewnia bezpośredni dostęp do aktywności o wysokiej częstotliwości (HFA), wskaźnika nieoscylacyjnej aktywności neuronowej, który odzwierciedla lokalne przetwarzanie informacji.

Podobnie nieliniowe modele dekodowania z kory słuchowej i sensomotorycznej zapewniły najwyższą dokładność dekodowania i niezwykłą zdolność rekonstrukcji zrozumiałej mowy. Dlatego zespół połączył modele dekodowania iEEG i nieliniowego, aby odkryć dynamikę neuronową leżącą u podstaw percepcji muzyki.

Zespół zmierzył także wpływ czasu trwania zbioru danych i gęstości elektrod na dokładność rekonstrukcji.

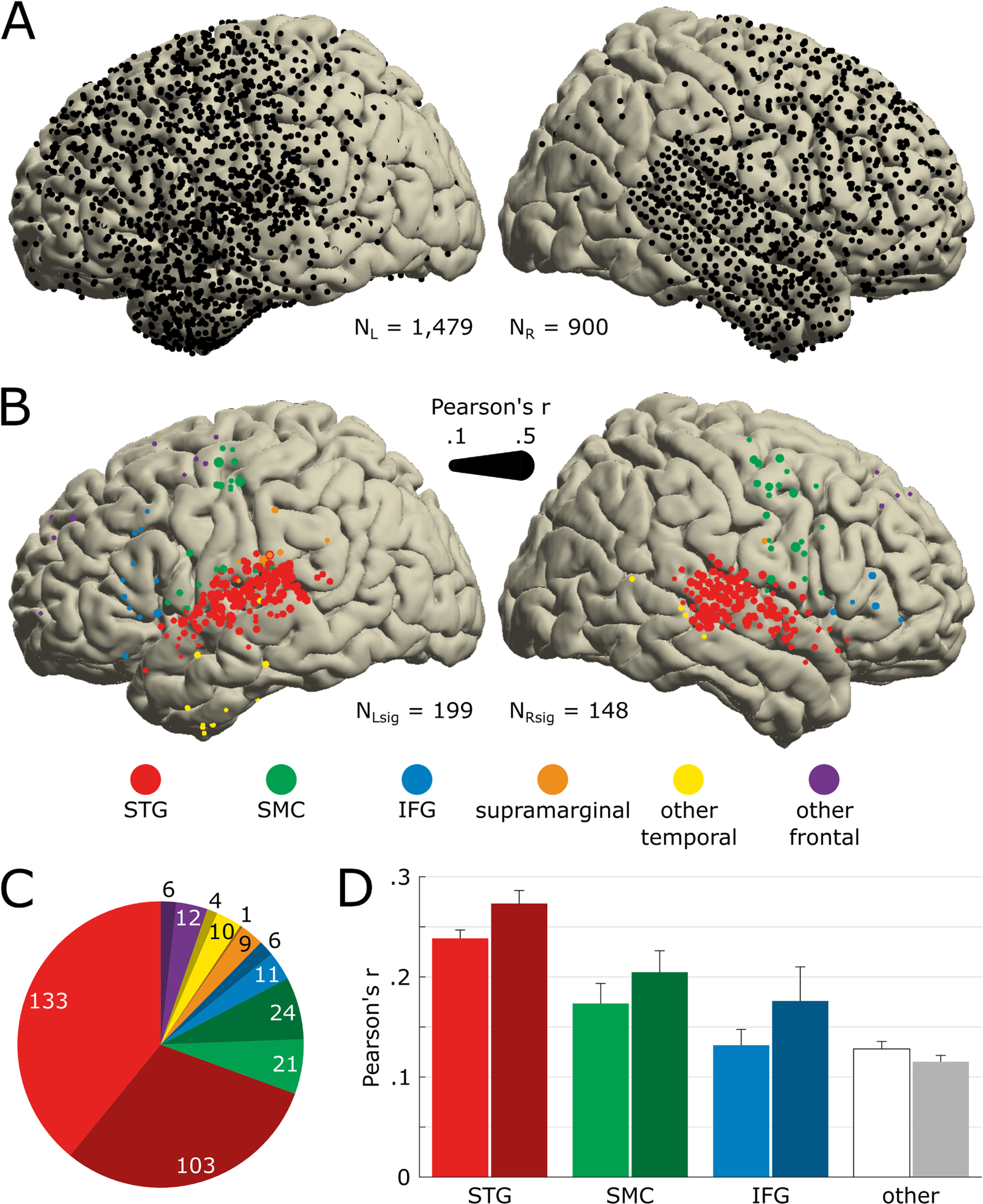

Anatomiczna lokalizacja elektrod reagujących na piosenkę.A) Pokrycie elektrodami dla wszystkich 29 pacjentów przedstawione na szablonie MNI (n=2379). Wszystkie dostarczone elektrody są wolne od jakiejkolwiek sztucznej lub epileptycznej aktywności. Lewa półkula jest narysowana po lewej stronie. (B) Lokalizacja elektrod, które w znaczący sposób kodują akustykę utworu (NSzałwia = 347). Istotność określono na podstawie dokładności przewidywań STRF metodą bootstrap na 250 próbkach ze zbiorów szkoleniowych, walidacyjnych i testowych. Kolor znacznika wskazuje na nomenklaturę anatomiczną ustaloną za pomocą atlasu FreeSurfer, a wielkość znacznika wskazuje na dokładność przewidywań STRF (współczynnik Pearsona pomiędzy rzeczywistym i przewidywanym HFA). W poniższych panelach i rysunkach używamy tego samego kodu koloru. (C) Liczba znaczących elektrod na obszar anatomiczny. Ciemny kolor wskazuje położenie prawej półkuli. (Dr) Średnia dokładność przewidywania STRF dla każdego obszaru anatomicznego. Elektrody wcześniej sklasyfikowane jako elektrody nadbrzeżne, inne elektrody skroniowe (tj. inne niż STG) i inne elektrody czołowe (tj. inne niż SMC lub IFG) są zgrupowane razem, oznaczone jako inne i przedstawione w kolorze białym/szarym. Słupki błędów wskazują SEM. Dane stojące za tym numerem można znaleźć pod adresem https://doi.org/10.5281/zenodo.7876019. HFA, aktywność o wysokiej częstotliwości; IFG, dolny zakręt czołowy. MNI, Instytut Neurologii w Montrealu; SEM, błąd standardowy średniej; SMC, kora sensomotoryczna. STG, zakręt skroniowy górny; STRF oznacza Spectral Temporal Receptive Field.https://doi.org/10.1371/journal.pbio.3002176.g002

wyniki

Wyniki badania wykazały, że w przetwarzanie muzyki zaangażowane są obie półkule mózgu, przy czym w percepcji muzyki ważniejszą rolę odgrywa zakręt skroniowy górny (STG) w prawej półkuli. Ponadto, chociaż płaty skroniowe i czołowe były aktywne podczas percepcji muzyki, nowy podregion STG został dostrojony do rytmu muzycznego.

Dane z 347 z prawie 2700 elektrod ECoG pomogły badaczom odkryć kodowanie muzyki. Dane wykazały, że obie półkule mózgu były zaangażowane w przetwarzanie muzyki, przy czym elektrody w prawej półkuli reagowały na muzykę aktywniej niż w lewej półkuli (16,4% w porównaniu z 13,5%), co stanowi bezpośredni kontrast w przypadku mowy. Warto zauważyć, że mowa wywołuje ważniejsze reakcje w lewej półkuli mózgu.

Jednak w obu półkulach większość elektrod reagujących na muzykę została wszczepiona w obszarze zwanym zakrętem skroniowym górnym (STG), co sugeruje, że prawdopodobnie odgrywały one kluczową rolę w percepcji muzyki. STG znajduje się tuż nad i za uchem.

Co więcej, wyniki badania wykazały, że modele nieliniowe zapewniają najwyższą dokładność dekodowania, r-kwadrat, wynoszącą 42,9%. Jednakże dodanie elektrod powyżej pewnej ilości zmniejsza również dokładność dekodowania; Zatem usunięcie 43 prawidłowych elektrod rytmicznych zmniejszyło dokładność dekodowania.

Elektrody zawarte w modelu dekodującym posiadały unikalne cechy funkcjonalne i anatomiczne, które również wpływały na dokładność dekodowania modelu.

Wreszcie, jeśli chodzi o wpływ czasu trwania zbioru danych na dokładność dekodowania, autorzy zauważają, że model osiągnął 80% maksymalnej zaobserwowanej dokładności dekodowania po 37 sekundach. Wynik ten podkreśla zastosowanie metod modelowania predykcyjnego (zastosowanych w tym badaniu) w małych zbiorach danych.

Dane z badania mogą mieć wpływ na zastosowania interfejsu mózg-komputer (BCI), na przykład narzędzia komunikacyjne dla osób niepełnosprawnych z zaburzeniami mowy. Ponieważ technologia BCI jest stosunkowo nowa, dostępne interfejsy oparte na BCI generują mowę o nienaturalnej, robotycznej jakości, która może ulec poprawie po włączeniu elementów muzycznych. Co więcej, wyniki badania mogą mieć znaczenie kliniczne dla pacjentów z zaburzeniami przetwarzania słuchowego.

Wniosek

Nasze wyniki potwierdzają i poszerzają wcześniejsze ustalenia dotyczące percepcji muzyki, w tym zależności percepcji muzyki od sieci dwustronnej z prawą stroną. W ramach przestrzennego rozkładu informacji muzycznej zbędne i unikalne komponenty były rozmieszczone odpowiednio pomiędzy STG, środkowym zakrętem skroniowym (SMC) i dolnym zakrętem czołowym (IFG) w lewej półkuli i skoncentrowane w STG w prawej półkuli.

Przyszłe badania mogłyby mieć na celu rozszerzenie zasięgu elektrod na inne obszary korowe, zmianę cech nieliniowych modeli dekodowania, a nawet dodanie wymiaru behawioralnego.

„Twitter geek. Nieprzejednany czytelnik. Dumny fanatyk mediów społecznościowych. Subtelnie czarujący muzyczny nerd.”

More Stories

Cate Blanchett dostała owacje na stojąco w Cannes z powodu plotek

IF Ryana Reynoldsa w dniu otwarcia zarobił 10,3 miliona dolarów

Lista spoilerów WWE SmackDown na odcinku 17.05.24