Jedną z głównych metod obrony stosowanych przez tych, którzy przodują w generatorach dzieł sztuki ze sztuczną inteligencją, jest to, że chociaż modele są szkolone na istniejących obrazach, wszystko, co tworzą, jest nowe. Misjonarze sztucznej inteligencji często Porównaj te systemy z prawdziwymi artystami. Twórcy czerpią inspirację ze wszystkich, którzy byli przed nimi, więc dlaczego nie upodobnić AI do poprzedniego dzieła?

Nowe badania mogą obalić ten argument, a nawet stać się głównym punktem spornym Kilka toczących się procesów sądowych związanych z treściami generowanymi przez sztuczną inteligencję i prawami autorskimi. Naukowcy zarówno z przemysłu, jak i ze środowisk akademickich odkryli, że najpopularniejsze i nadchodzące generatory obrazów AI mogą „zapisywać” obrazy z danych, na których zostali przeszkoleni. Zamiast tworzyć coś zupełnie nowego, niektóre monity sprawią, że sztuczna inteligencja po prostu odtworzy obraz. Niektóre z tych odtworzonych obrazów mogą być objęte prawami autorskimi. Ale co gorsza, nowoczesne modele generatywne sztucznej inteligencji mają możliwość zapisywania i odtwarzania poufnych informacji zebranych do wykorzystania w zestawie szkoleniowym sztucznej inteligencji.

uczenie się Prowadzone przez badaczy technologii – dokładnie Google i DeepMind – oraz na uniwersytetach takich jak Berkeley i Princeton. Pracowała ta sama ekipa poprzednie badanie który zidentyfikował podobny problem z modelami języka AI, w szczególności GPT2, Wprowadzenie do modeli OpenAI ChatGPT jest niezwykle popularny. Łącząc zespół ponownie, badacze kierowani przez badacza Google Brain, Nicholasa Carliniego, odkryli, że zarówno Google Imagen, jak i popularna open source Stable Diffusion były w stanie odtworzyć obrazy, z których niektóre miały oczywiste implikacje dotyczące praw autorskich i licencji.

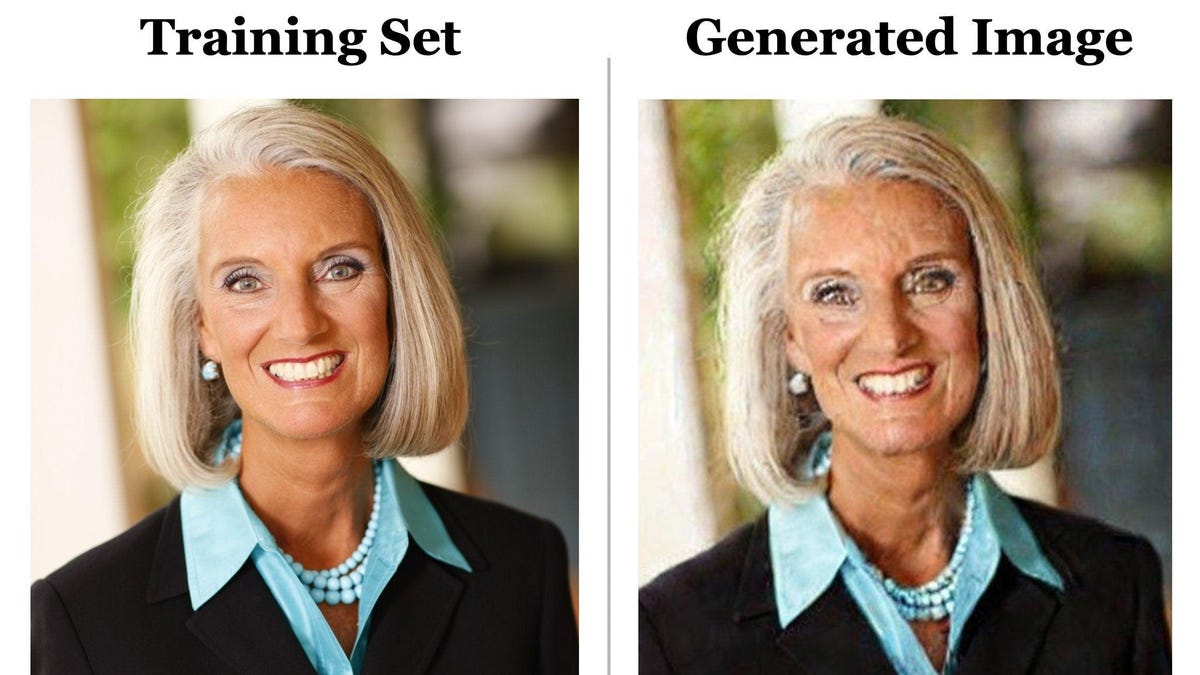

Pierwszy obraz w tym tweecie został utworzony przy użyciu podpisu zawartego w zbiorze danych Stable Diffusion, wieloterabajtowej pofragmentowanej bazie danych obrazów znanej jako LAION. Zespół umieścił podpis w monicie „Stabilna dyfuzja” i wyszedł z dokładnie tym samym obrazem, choć nieco zniekształconym przez szum cyfrowy. Proces znajdowania tych zduplikowanych zdjęć był stosunkowo prosty. Zespół uruchomił ten sam monit kilka razy, a po uzyskaniu tego samego obrazu wynikowego badacze ręcznie sprawdzili, czy obraz był obecny w zbiorze treningowym.

G/O Media może otrzymywać prowizję

Dwóch badaczy z artykułu, Eric Wallace, doktorant z UC Berkeley, i Vikash Siwag, doktorant z Princeton University, powiedzieli Gizmodo w wywiadzie Zoom, że replikacja obrazu jest rzadka. Ich zespół wypróbował około 300 000 różnych napisów i stwierdził, że wskaźnik zapamiętywania wynosi zaledwie 0,3%. Zduplikowane obrazy były znacznie rzadsze w przypadku modeli takich jak Stable Diffusion, które deduplikowały obrazy w swoim zbiorze treningowym, chociaż ostatecznie wszystkie modele dyfuzji będą miały ten sam problem, w większym lub mniejszym stopniu. Naukowcy odkryli, że Imagen był w stanie doskonale zapamiętać obrazy, które istniały tylko raz w zbiorze danych.

„Zastrzeżenie polega na tym, że model ma generalizować i ma generować nowe obrazy, a nie wypluwać kopię przechowywaną w pamięci” – powiedział Sehwag.

Ich badania pokazują, że w miarę jak systemy sztucznej inteligencji stają się większe i bardziej złożone, wzrasta prawdopodobieństwo, że sztuczna inteligencja wytworzy replikowany materiał. Mniejszy model, taki jak Stable Diffusion, po prostu nie ma takiej samej ilości miejsca do przechowywania większości danych treningowych. że Wiele może się zmienić w ciągu najbliższych kilku lat.

„Może w przyszłym roku, niezależnie od tego, jaki pojawi się nowy model, który będzie o wiele większy i potężniejszy, tego rodzaju zagrożenia dla ochrony będą prawdopodobnie znacznie wyższe niż obecnie” – powiedział Wallace.

Dzięki złożonemu procesowi, który obejmuje niszczenie danych treningowych za pomocą szumu przed usunięciem tej samej deformacji, modele uczenia maszynowego oparte na dyfuzji generują dane — w tym przypadku obrazy — podobne do tych, które zostały na nich wytrenowane. Modele dyfuzji były ewolucją generatywnych sieci kontradyktoryjnych lub uczenia maszynowego opartego na GAN.

Naukowcy odkryli, że modele oparte na GAN nie mają takiego samego problemu z zapisywaniem obrazów, ale jest mało prawdopodobne, aby duże firmy wyszły poza Diffusion, chyba że pojawi się bardziej wyrafinowany model uczenia maszynowego, który wytwarza bardziej realistyczne obrazy o wyższej jakości.

Florian Trammer, profesor informatyki na ETH Zurich, który był zaangażowany w badania, zauważył, jak wiele firm zajmujących się sztuczną inteligencją doradza użytkownikom, zarówno w wersji darmowej, jak i płatnej, udzielenie licencji na udostępnianie lub nawet zarabianie na treściach generowanych przez sztuczną inteligencję. Same firmy AI również zastrzegają sobie pewne prawa do tych obrazów. Może to stanowić problem, jeśli sztuczna inteligencja utworzy obraz, który jest dokładnym dopasowaniem do istniejących praw autorskich.

Przy współczynniku oszczędności wynoszącym zaledwie 0,3% programiści AI mogą spojrzeć na to badanie i stwierdzić, że ryzyko nie jest zbyt duże. Firmy mogą pracować nad usunięciem duplikatów obrazów w danych szkoleniowych, zmniejszając prawdopodobieństwo ich zapisania. Do diabła, mogliby nawet opracować systemy sztucznej inteligencji, które mogą wykrywać, czy obraz jest bezpośrednim duplikatem obrazu w danych treningowych i oflagować go do usunięcia. Ukrywa jednak pełne zagrożenie dla prywatności stwarzane przez generatywną sztuczną inteligencję. Carlini i Trammer również pomogli Kolejny niedawny artykuł Na co argumentowałem, że nawet próby filtrowania danych nadal nie zapobiegły wyciekowi danych treningowych przez model.

I oczywiście istnieje duże ryzyko, że na ekranach użytkowników pojawią się obrazy, których nikt nie chce reprodukować. Wallace zapytał, czy badacz chciałby stworzyć pełny zestaw syntetycznych danych medycznych, na przykład do zdjęć rentgenowskich ludzi. Co powinno się stać, jeśli sztuczna inteligencja oparta na dyfuzji zostanie uratowana I duplikować faktyczną dokumentację medyczną danej osoby?

„To bardzo rzadkie, więc na początku możesz nie zauważyć, że tak się dzieje, a potem możesz faktycznie opublikować ten zestaw danych w Internecie” – powiedział student UC Berkeley. „Celem tej pracy jest wyprzedzenie potencjalnych rodzajów błędów, które ludzie mogą popełnić”.

„Twitter geek. Nieprzejednany czytelnik. Dumny fanatyk mediów społecznościowych. Subtelnie czarujący muzyczny nerd.”

More Stories

Barry Keoghan dołącza do Cilliana Murphy’ego w serialu Netflix „Peaky Blinders”.

Koreańska piosenkarka popowa Taeil opuszcza grupę śpiewającą z powodu oskarżeń o przestępstwa na tle seksualnym

„Swifties for Kamala” zbiera pieniądze od celebrytów i pieniądze na kampanię dla Demokratów